Wenn man einen Laien auf der Straße fragen würde, was er meint, was ein Supercomputer ist, würde er wahrscheinlich zu einem großen Prozentsatz Beispiele aus populären Filmen zitieren – und zwar in der Regel Beispiele mit einem schlechten Ruf. Von HAL 9000 (2001: A Space Odyssey) bis hin zu VIKI aus iRobot und sogar Skynet aus Terminator: In der Popkultur werden Supercomputer oft als empfindungsfähige Systeme dargestellt, die sich entwickelt und gegen die Menschheit gewandt haben.

Erzählen Sie das mal den Forschern des Lawrence Livermore National Laboratory oder des National Weather Service, dann biegen die sich vor Lachen. Die Wahrheit ist, dass Supercomputer heute weit davon entfernt sind, sich ihrer selbst bewusst zu sein, und die einzige KI ist im Wesentlichen eine aufgeblähte Suchleiste, die sehr große Datensätze durchsucht.

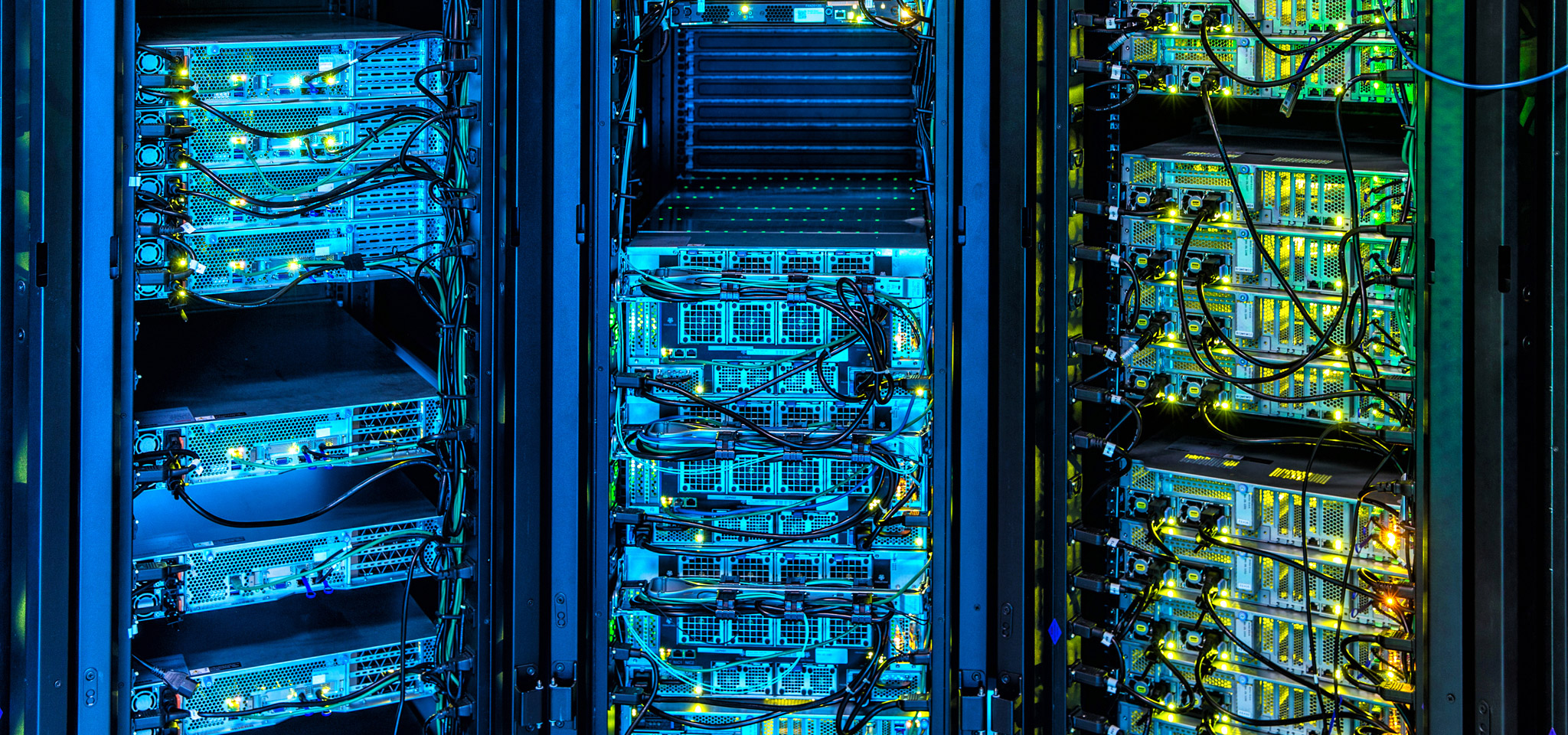

Supercomputer steuern heute eine Vielzahl von Anwendungen, die an der Spitze des Fortschritts stehen: von der Öl- und Gasexploration über Wettervorhersagen, Finanzmärkten bis hin zur Entwicklung neuer Technologien. Supercomputer sind die Lamborghinis oder Bugattis der Computerwelt und bei Kingston schenken wir den Fortschritten, die die Grenzen des computerbasierten Rechnens weiter nach vorn verschieben, große Aufmerksamkeit. Von der DRAM-Nutzung und -Abstimmung über Firmware-Fortschritte bei der Verwaltung von Speicher-Arrays bis hin zum Nachdruck auf Konsistenz von Übertragungs- und Latenzgeschwindigkeiten anstelle von Spitzenwerten haben unsere Technologien einen großen Einfluss auf die Spitzentechnologie des Supercomputings.

In ähnlicher Weise gibt es viele Dinge, die Manager von Cloud- und Vor-Ort-Rechenzentren vom Supercomputing lernen können, wenn es darum geht, ihre Infrastrukturen zu gestalten und zu verwalten, auch bei der Auswahl der Komponenten, die für zukünftige Weiterentwicklungen bereit sind, ohne dass sie großen Erneuerungen unterzogen werden müssen.