如果在街上询问门外汉对超级计算机的看法,很可能大部分人都会提到热门电影里的例子,尤其是那些臭名昭著的例子。从哈尔 9000《2001:太空漫游》到《我,机器人》中的 VIKI,甚至是《终结者》中的天网,流行文化常常会把超级计算机描绘成实现了进化并背叛了人类的有意识系统。

如果将这些告诉美国劳伦斯利弗莫尔国家实验室或国家气象服务局的研究员,他们则会一笑置之。事实上,当今的超级计算机远远谈不上有意识,唯一的 AI 基本上是被夸大的搜索条,用于搜索超大型数据集。

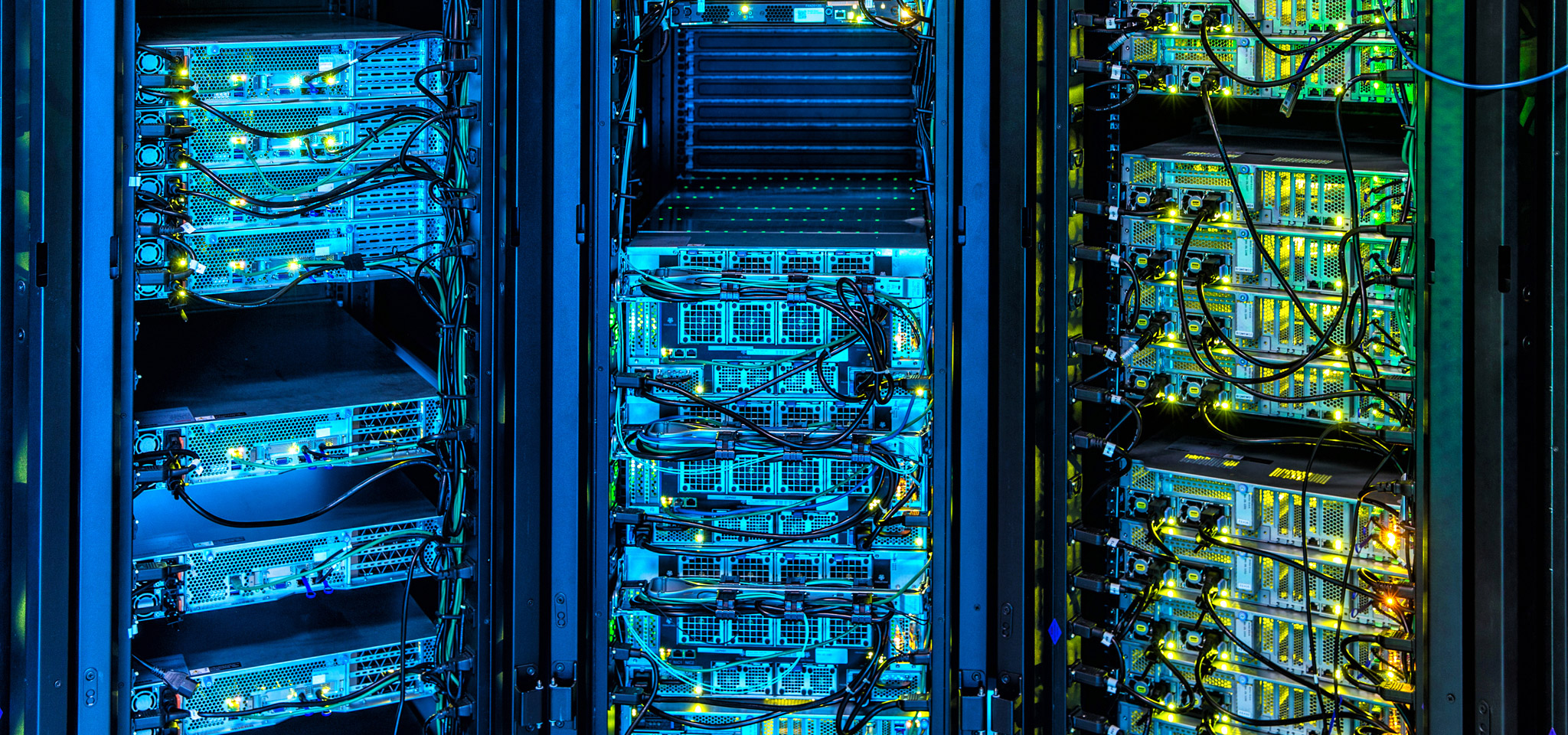

今天,超级计算机为处于发展最前沿的众多应用提供了支持:从石油天然气勘探到天气预测,从金融市场到新技术开发,涉及方方面面。超级计算机如同计算机世界的兰博基尼或布加迪,在金士顿,我们非常关注在计算方面取得的突破性进步成果。从 DRAM 优化和调优,到固件在存储阵列管理方面的进步成果,再到对传输一致性与延迟速度而非峰值数值的重视,我们的技术深深影响着超级计算的前沿技术。

同样,云数据中心和组织内部数据中心的经理们可在两个方面从超级计算学到许多东西,一是基础架构设计和管理,二是如何完美选择组件,既能为未来发展做好准备,又无需庞大的改造。