La capacidad de aumentar el rendimiento de la interfaz SATA ha hecho que la mayoría de los centros de datos sean lentos en adoptar la tecnología NVMe. Es más fácil aumentar la capacidad o aumentar el rendimiento con IOPS más altas o una latencia más baja cuando usa algo lento como SATA. Si observa los centros de datos actuales, la mayoría de los arquitectos de centros de datos se centran en mejorar la utilización de la CPU. Con un bastidor o rack lleno de CPUs costosas (independientemente de la cantidad de núcleos o los costos de licencia pagados), los centros de datos rara vez son capaces de utilizar las CPUs hasta cerca del treinta por ciento de su capacidad máxima.

Imagínese pagar por una sala de servidores llena de Ferraris solo para terminar estancado conduciéndolos a 20 mph. Este no es un problema Ford contra Ferrari, sino más bien un problema de combustible sin plomo contra alto octanaje.

NVMe está impulsando un nuevo cambio con velocidades de transferencia y aprovisionamiento en memoria, lo que le permite duplicar la utilización del treinta a casi el sesenta por ciento. Usando la infraestructura existente, NVMe puede hacer que las CPUs se ejecuten de manera más eficiente con menor latencia y mayor rendimiento. Sin embargo, debe poder acomodarse al NVMe. Las limitaciones pueden incluir sus placas base existentes o la imposibilidad de conectar y reemplazar por su factor de forma actual. Se convierte en una remodelación mas amplia.

Para pasar de un sistema basado en SAS, la arquitectura del servidor debe cambiar a menos que use un adaptador para meter un SSD NVMe en el bus PCIe. Esto será un cambio de plataforma completo para un cliente. En comparación con el uso de controladores huésped basados en hardware SATA y SAS, la interfaz PCIe está definida por software y ofrece una mayor eficiencia a los procesos exclusivos. Es asombroso cómo NVMe proporciona baja latencia y la capacidad de las CPUs para hacer multiproceso.

Ahora, la siguiente pregunta que podría hacer es: "¿Qué es más importante en la actualidad? ¿Actualizar todo el automóvil o simplemente turboalimentar el motor? "

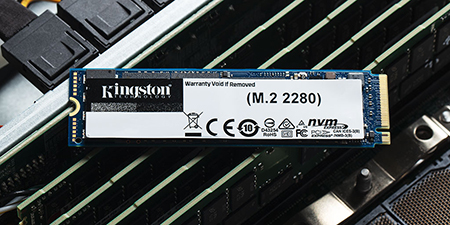

Para la mayoría de los administradores de centros de datos, el cambio será gradual, comenzando con ligeras actualizaciones como el DC1500M y DC1000Bde Kingston